前言

介绍说明

Stable Diffusion (稳定扩散) 是一个扩散模型,2022年8月由德国CompVis协同Stability AI和Runway发表论文,并且推出相关程序。

Stable Diffusion WebUI能够支持多系统使用,无论是Linux/Windows还是MacOS,现在都已支持使用。Stable Diffusion WebUI有着极为广泛的插件生态,能够实现远超Midjoruney/NovelAI的自由度和实用价值。

AUTOMATIC1111所开发的Stable Diffusion WebUI是目前使用最为广泛的AI图像生成开源软件,本文章将围绕Stable Diffusion WebUI展开相关内容的说明。

特别致谢

【AI绘画lora交流群】群友帮忙完善了LoRA训练相关的内容

【XDiffusion AI绘画研究交流】帮忙挑刺,找出了一部分文章的错误内容

【元素法典组】

【秋叶的甜品店】

【幻想魔法书—旧日黎明】帮忙制作了文章框架,补充了部分内容

【珊瑚宫︱数字生命研究所】

避坑指南

①任何在x宝、x鱼等平台售卖AI整合包的,全部都是坑钱的

②任何AI绘画相关课程都是大冤种课程,也都是坑钱的

③任何收费出售AI模型、LoRA、付费生成的AI绘画相关内容,都是坑人的

④任何平台的:例如“我的二次元形象”“无尽三月七”等活动,在一般的SD中只需要一个LoRA就可以轻松解决

⑤国内所有的AI绘画APP都不要使用、大概率也是坑你钱的

⑥国内绝大部分模型站都最好不要使用(出现过很多离谱操作),如有需要请使用civitai和huggingface(civitai大家一般都简称C站,C站可能会上不去,huggingface简称抱抱脸,很多时候国内的交流群都比较喜欢用简称来称呼这两个网站)

⑦当civitai上不去的时候可以使用 吐司 Tusi.cn 这个网站网站中的C站镜像。

一些链接:

1. 潜工具书

新人最推荐查看的AI绘画最全工具书

2. 新手入门

推荐关注up:秋葉aaaki 入门可以去看其专栏和视频

3. 提示词

提示词全解:

元素法典:1和1.5卷因为部分问题不做推荐,新人也不建议查看

一些玄学的东西的纠错与解释

4. 模型站

AiTool.ai – Explore the world of AI

5. 本文参考链接

Stable Diffusion WebUI使用手冊(简体中文)

[調査] Smile Test: Elysium_Anime_V3 問題を調べる #3|bbcmc (note.com)

THE OTHER LoRA TRAINING RENTRY

Home · AUTOMATIC1111/stable-diffusion-webui Wiki (github.com)

如何识别AI图片:

目前由 AI 绘制的插图完成度已经逼近甚至超越了真人画师,所以粗略查看是无法区分是否由 AI 绘制。

1. 误区

a. AI图并非画不好手,也并非是那种油腻的“AI风格”

b. 网上的各种分辨网站/软件,经实测识别成功率最高的仅有40%的置信度,所以仅看个乐就行

c. 对于经常玩AI绘画的人来说,AI图基本可以做到一眼分辨

2. 分辨方法

通过模型分辨

部分热度较高的模型都有对应相对固定的风格,能够识别这些风格就能做到接近70%以上的置信率

扩散生成痕迹

AI生成图片并非是理解了图片画什么怎么画,而是通过反向扩散的方法直接生成图片,这种生成痕迹会有一些较为明显的特征

这种痕迹是绝大部分模型都无法避免的,具体来说就是:包括但不限于衣服褶皱、皮肤褶皱、头发效果上出现莫名其妙不合逻辑的纹路、以及部分不应该出现的噪点。其次还有,部分AI图也存在本来不应该在同一位置的物品相连接或者相融合的情况。

图像细节问题

这个方法是最后的方法,再上面两种一眼丁真的方法都不起作用的时候再来用这个。

例如AI会在左右眼形状和高光的一致性、服装对称性、重复形状一致性、几何图形的正确与否等方面出现问题。

SD部署和使用,神奇的AI绘画在这里

1. 部署stable diffusion webui

首先你得有Stable Diffusion WebUI框架和模型,没有部署SD,玩个P的AI绘画。

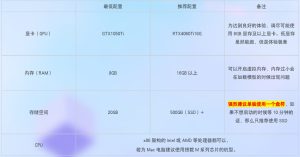

硬件需求

● 显卡VRAM在4GB以下的会很容易遇到显存不足的问题,即使使用放大插件也就非常慢(以时间换显存)

● 显卡VRAM在4GB以下的会很容易遇到显存不足的问题,即使使用放大插件也就非常慢(以时间换显存)

● 可以开启CPU模式,但是速度依旧是非常慢。你不希望一个小时一张图的话那就别想着用CPU跑图

操作系统需求

Linux:Debian11(这个我在用)

(除此之外我并不知道那些版本可以正常使用,如有需要可以先下载贴吧整合包测试)

Windows:最低要求为Windows 10 64比特,请确保系统已更新至最新版本。

windows7就不要想了,建议直接升级到win10/win11

macOS:最低要求为macOS Monterey (12.5),如果可以的话请使用最新版macOS。

建议使用搭载Apple Silicon M芯片 (M1、M2) 的Mac机型。

旧款Mac需配备AMD独立显卡,只有Intel核显的不能使用。

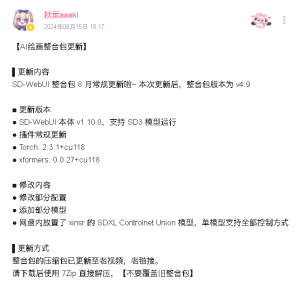

整合包部署

如果你是从零开始,这里推荐秋葉aaaki一键包和启动器。

【【AI绘画】Stable Diffusion整合包v4发布!全新加速 解压即用 防爆显存 三分钟入门AI绘画 ☆可更新 ☆训练 ☆汉化】 https://www.bilibili.com/video/BV1iM4y1y7oA/?share_source=copy_web&vd_source=b315aefe546aaa25153160a5d2c908c4 备用链接:

【【AI绘画】绘世启动器正式发布!一键启动/修复/更新/模型下载管理全支持!】 https://www.bilibili.com/video/BV1ne4y1V7QU/?share_source=copy_web&vd_source=b315aefe546aaa25153160a5d2c908c4

(除了以上推荐外,还有星空等少数大佬发布启动器或一键包。)

在此建议,有条件在电脑上本地部署,就尽量本地部署。没条件,可以考虑云端部署,请在B站等地搜索相关教程学习部署。目前市面上的APP暂不推荐,很多是收费的,很多只有少量的免费时长。而且大多数APP不具备完整的功能,不适合系统性的学习和进步。

2. 添加ckp大模型

NovelAI 和Anything分别是什么?

NovelAI是一个二次元AI生成图片的网站。因为泄漏事件,NAI 使用数千万 Danbooru(图站)图片训练的模型被泄漏了两次。

事件报告

泄露 Part 1 —— 包含生产模型,程序 —— 53.66 GB,其中相关模型有 7GB 和 4GB 两种。

泄露 Part 2 —— 包含历史测试代码和模型,程序 —— 124.54 GB,其中相关模型与 Part1 相同。Anything是由元素法典组的千秋九制作的一个融合模型。因为其效果在当时来看较好,并且受到众多营销号的吹捧而广为人知。

如何添加ckp大模型

部署完成后,将下载的模型放到WEBUI根目录中的model/Stable-diffusion文件夹中。ckp大模型的大小一般为1.6G及以上,后缀为.safetensors。

当然了有的整合包自带有ckp大模型,当你看到WEBUI根目录中的model/Stable-diffusion里面有模型文件的时候,那么可以暂时跳过这个步骤,直接使用整合包自带的模型。

注意:

①除非你完全可以信任这个模型,那么请尽量避免使用.ckpt后缀的模型。

②请不要听从其他人的任何建议,关闭模型检查。请及时拉黑让你开启允许加载不安全模型这个选项的人。

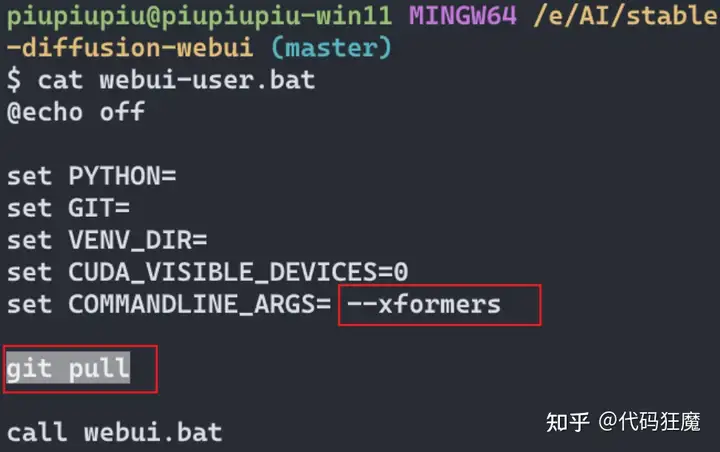

3. 运行WebUI实例

点击启动器上的启动按钮以启动你的webui实例,没有启动器的整合包请按照视频说明启动。如果不使用启动器和整合包,则点击webui-user.bat

![]()

4. 常见问题

一般而言,遇到的问题可以根据启动器所提示的内容解决。启动器无法识别的报错可以尝试复制到翻译软件简单翻译一下,若不知道如何解决,则可以到对应的交流讨论区询问。

注意:没人愿意只凭借一个不正常退出的提示截图就给你解决问题,请上传完整的报错截图。没有错误日志就诊断问题无异于闭眼开车。

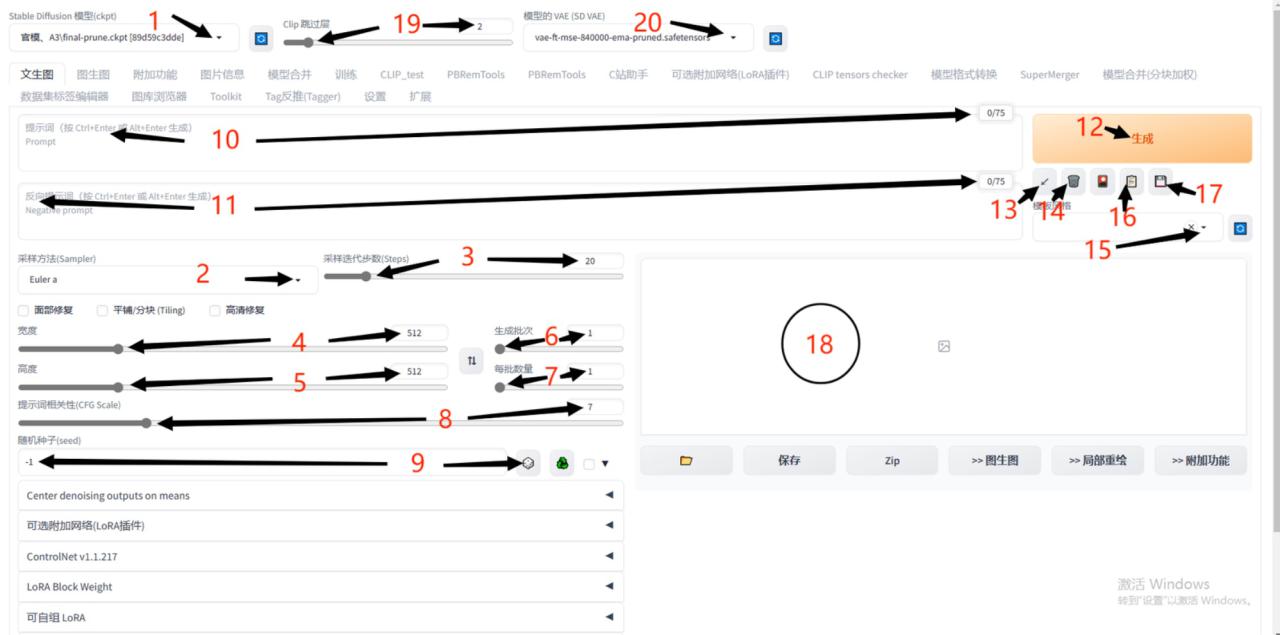

5. 基础参数说明

以一个普通的WebUI界面为例。如果你的界面色彩不同或选项更少或更多,不用奇怪,这是正常的。笔者下载了一些插件,仅此而已。只需要看看该界面那些参数、选项有什么作用,效果就达到了。

一般而言只需要记住这张图就好了,详细的说明在下面

一般而言只需要记住这张图就好了,详细的说明在下面

1. 大模型:不管你的模型是ckpt格式,还是safetensors格式,这里可以选择你的模型,或调换模型。右箭头指向的小三角形,点开就可切换模型。关于模型的作用和推荐,后文讲解。

1. 大模型:不管你的模型是ckpt格式,还是safetensors格式,这里可以选择你的模型,或调换模型。右箭头指向的小三角形,点开就可切换模型。关于模型的作用和推荐,后文讲解。

2. 采样方法:也称采样器。最古老的好像是Euler和Euler a,DDIM曾经相当火。当下用的最多的是DPM++ 2S a Karras、DPM++ 2M Karras、DPM++ SDE Karras,其他采样器也可以尝试,有时会有出色的表现。采样器会影响出图速度,DPM++ 2M Karras、DDIM、UniPC等几个采样器生成速度快,但太低步数图片会崩坏,建议不用高清修复时不低于20步,用高清修复不低于10步。(并非绝对)

3. 采样迭代步数:一般称步数。并非越高越好。不开高修约30至50步够用,开高修15至25步够用。当你已经很熟练,可以无视此条。

4. 图片宽度:简称宽。必须为8的倍数。太小的图不好看,图越大越模型会不知道生成什么导致糟糕的输出。如果没有固定的要求,请按显卡能力和需求适当调整。如果爆显存了,那就调小一些。

5. 图片高度:简称高。必须为8的倍数。太小的图不好看,图越大越吃显存。如果没有固定的要求,请按显卡能力和需求适当调整。如果爆显存了,那就调小一些。

6. 生成批次:批量生产图片时调整这个。

7. 每批数量:很多新手批量生产图片喜欢点这个,这是错误的。它很考验你的显卡,图越大越要慎选。一般默认的1就可以。

8. 提示词相关性(CFG):数值越大tag越精准,数值越小想象越丰富同时越不听话,不建议开启太高的CFG。但如果开启较大CFG出现了糟糕的图片,请改用CFG修复插件: mcmonkeyprojects/sd-dynamic-thresholding: Dynamic Thresholding (CFG Scale Fix) for SD Auto WebUI (github.com)

9. 随机种子:简称种子。一般为-1(随机生成),当需要锁种子调参数做对比,复制生成图的种子填进这里即可。同种子同参数同模型同tag,生成的图片一定是几乎看不出差别的。(因不同显卡不同环境会出现有些微影响,但是并不严重)

10. 正面提示词:一般称tag,或称正面tag、正面。新手建议抄正面tag进行尝试,并在抄来的基础上进行改动,请勿徒手乱捏。很复杂,这里只做简单的解释,详情见提示词教程。

11. 负面提示词:一般称负面tag,或负面。新手建议不要深入研究,用抄来的就好。一般越短的负面越听话,越长的越不听话。同时,负面tag的权重也有影响,过高或者过低都有不利影响。

12. 生成:点击生成前请确认tag是否准备完毕,参数是否在合理的数值,确认无误,即可开启奇妙之旅。

13. 自动填充提示词和参数:很少用。如果你关闭界面时忘了保存,再次生成时想要找到上一次的提示词和参数,点这个是最快捷的方法。

14. 清空提示词:当你要把正面和负面全部删除,点这个是最快捷的方法。

15. 模板风格:非常好用的功能,你可以从中选择想要的已储存的提示词,迅速加载。配合16和17使用。

16. 将已选择的模板风格写入当前提示词:要先选择15模板风格才能生效。

17. 将当前的提示词保存为模板风格:对于经常使用的提示词,在此保存一下,想用的时候14清空提示词,15选择模板风格,16写入提示词,其他只剩调参数。

18. 图片展示区域:你生成的图片在此会展示出来。生成图片的过程中有进度条的,跑到100%就生成完毕了。如果图片不见了,可能是爆显存,请查看该区域下方的提示栏。

19. Clip跳过层:简称Clip。默认为2,新手请勿调整。

20. 模型的VAE:简称VAE。这里是外挂VAE的地方。

6. 高清修复说明

高清修复Hires.fix是用来生成较大图片防止AI模型乱画的一个功能。一般而言需要配合分块VAE插件使用防止爆显存

高清修复Hires.fix是用来生成较大图片防止AI模型乱画的一个功能。一般而言需要配合分块VAE插件使用防止爆显存

一般而言,二次元图片使用Anime6B采样器。除此之外,放大的倍率也不能开太大,不然极其容易出现古神图等情况。

一般而言,二次元图片使用Anime6B采样器。除此之外,放大的倍率也不能开太大,不然极其容易出现古神图等情况。

另外,没必要一直开启高清修复。看到了自己想要的构图/大致效果后再开启高清修复可以极大的节省抽卡生成的时间。

你热爱的,就是你的parameters

自从AI绘画出现以来,各种参数的讨论就从未停止过。

1. “我会画画了!”生成你的第一张AI图

在对应的提示词框,然后点击生成就可以生成你的第一张AI图了

提示词:

cute little girl,,solo,wind,pale-blonde hair, blue eyes,very long twintails,white hat,blue sky,laugh,double tooth,,lens flare,dramatic, coastal,

flying petal, flowery field, sky, sun,field, sunflower, masterpiece, best quality,反向提示词

(mutated hands and fingers:1.5 ),(mutation, poorly drawn :1.2),(long body :1.3),(mutation, poorly drawn :1.2),liquid body,text font ui,long neck,uncoordinated body,fused ears,(ugly:1.4),one hand with more than 5 fingers,one hand with less than 5 fingers,上面的提示词大体效果是这样的↓

如果你想要达到更好的效果,那么修改相关的参数就是必不可少的。下面呢就是有关生成个提示词相关参数的部分介绍。

如果你想要达到更好的效果,那么修改相关的参数就是必不可少的。下面呢就是有关生成个提示词相关参数的部分介绍。

当然了,如果不满足于文章中给的这些内容,你也可以去参考更为详细的元素同典:具体链接在本模块的最下面。

2. 提示词的范例

当然了,新人想要得到比较好的AI生成图可以看以下几个提示词合集。

但是需要知道的一点是:推荐参数绝非必须的数值,这些仅供新人参考,入门后其实是不需要任何推荐参数的。

下面的内容,就是写详细的讲解“魔法师”是如何写出这些“咒语”来的:

3. 书写你的第一段“咒语”

咒语是什么?

在AI绘画中,我们使用一段 prompt 来引导U-net对随机种子生成的噪点图进行“降噪”,从而生成我们想要的东西。

Prompt (提示词,又译为关键词)通常由英文构成,主要内容为以逗号隔开的单词/词组/短句。prompt 也可以包括其它语言的文字,但效果往往不佳。prompt 还可以识别一些特殊符号。

AI 会通过寻找符合关键词描述的噪点图进行有明确指向的去噪点(diffuse)。同样,如果包含 Negative Prompt(负面关键词),AI 就会尽可能避免含有负面相关要素的去噪点方式。换句话说,prompt 就像是哈利波特里面的咒语,它直接决定了最终我们会得到什么。

简而言之就是你想要什么那就写道正面提示词里,你不想要什么,那就写到负面提示词里。比如我想要“一个穿着白色裙子带着白色帽子的女孩站在花丛里”那么我们可以写以下提示词:

1girl,white dress,white hat,stand,flowers这时候点击生成,就会出现左边这样的生成图。

如果理解了这以方面,那么恭喜你,你已经学会了基本简单的提示词写法了。你可以尝试一下自己喜欢的内容,多生成几张AI图尝试尝试这个过程

如果理解了这以方面,那么恭喜你,你已经学会了基本简单的提示词写法了。你可以尝试一下自己喜欢的内容,多生成几张AI图尝试尝试这个过程

如果对生成图片的质量不满意,那么怎么办呢?接下来只需要根据图片生成的结果,逐步细化提示词,并且添加质量词和负面提示词就可以了。

比如左边那张图看到天空比较空,那么就可以加上:cloud,sun等这种描述天空效果的提示词。当然如果英语水平限制了你的发挥,那么你也可以使用翻译软件来“施法”。

当然了,你也可以拿着这把“全村最好的剑”:

半自动魔导原典_免费高速下载|百度网盘-分享无限制 (baidu.com)

4. 学徒级语法【三段式】&如何写提示词

三段式与基本提示词写法

需要特别注意的是SDXL的模型并不适配SD1.5的语法和提示词顺序,这部分只作为SD1.5的提示词来使用,需要根据模型作者自己训练的方式来决定,所以在使用SDXL的训练模型的时候请注意查看模型卡

简而言之,三段式就是把质量词、主体、背景三者的描述分开进行。很多人在写提示词的时候会受到英语水平的限制,于是就提出了三段式语法,其目的是在较多提示词的时候能够一目了然的分辨内容,方便删减提示词和调整提示词的权重。这在当时元素法典时期使得大家能够快速的分享自己的提示词或者使用其他人的提示词。

质量词和效果词放最前面,人物与人物特征放在中间,背景和光效放以及功能性tag最后面,这是三段式的基础用法。

8k Wallpaper,grand,(((masterpiece))), (((best quality))), ((ultra-detailed)), (illustration), ((an extremely delicate and beautiful)),dynamic angle,

rainbow hair,detailed cute anime face,((loli)),(((masterpiece))),an extremely delicate and beautiful girl,flower,cry,

water,corrugated,flowers tire,broken glass,(broken screen),transparent glass.

前缀(质量词+画风词+整体效果)

质量词用于提升生成质量:

例如:masterpiece、best quality等

画风词用于凸显图片的画风:

例如:

冰箱贴前缀:

[(flat color,vector graphics,outline):1.35),(paper cutting:1.2)::0.6],

立绘法的前缀:

official art,1girl, simple background,[(white background:1.5)::0.2],open-mouth,(white background:1.2)

当然了,这些符号的意义将在后面详细讲解,现在看不懂也没关系

效果词为整体画面效果的提示词

例如:炫光lensflare、景深Depthoffield、 角色焦点character focus、从下面看from below等等

注意:部分固定(例如白背景立绘)这种属于风格类提示词,建议放到前缀里而非最后的背景

主体(画面中的主体部分)

主体为图画想要凸显的主体,可以是人物,建筑,景物等,主体部分要进行丰富的描述才能获得细节丰富的图像。

对于角色来说,通常包括了面部,头发,身体,衣着,姿态等描写。

没有角色时,可以将场景中的重要点即高耸如云的城堡,绽放的花朵,破碎的钟表等,想要位于画面中心的物体进行描述。

描述的顺序大致为由主到次,即你想要生成图中占据大部分画面的元素放到最前面。除此之外你想要生成违反生活常识经验/常见创作的元素的图你需要更为详细的描写或者更高的权重。

当 1 girl 和 earring 简单结合时,无论两者谁先谁后,最后都会变成“一个二次元美少女带着耳环”的样子,不会在简短描述下就轻易地出现诸如“美少女向前抬手捧着耳环、耳环在镜头前是一个特写、美少女的身体被景深虚化”的情况。因为在我们的生活常识中,大多数这两个“物”结合的情况都是前者,后者在作品描绘里出现的情况极少,因而这两者即使是顺序调换也只是让美少女是否摆出展示耳环的姿势,无法轻易地切换主次

继续深讲就到训练集的部分了,虽然它的本质是训练集与 LatentDiffusion 对于自然语言的处理,但考虑到大多数组成训练集的作品都取自于生活经验 / 常见创作想象,且自然语言处理本就是努力拟合生活经验的过程,所以实际上并无明显不同。

场景(背景,环境)

场景是主体存在的周围场景,没有场景描述时容易生成纯色背景或者是效果tag相关的背景,且主体会显得很大。部分主体会自带场景内容,例如建筑,景物。

例如:繁花草甸flowerymeadow,羽毛feather,阳光sunlight,河流river,碎玻璃Brokenglass等

此外,元素法典后期的提示词实际上并没有严格遵循三段式,具体原因是大家都开始研究分步语法,分步语法会将背景和主题放到同一模块,成为“两段式”,而非上面所说的三段式。

当然了有关分步渲染的相关内容,在下面【7.WebUI基本进阶用法】会有详细的讲解,现在看不懂也是没有关系的。

(((masterpiece))),(((crystals texture Hair))),(((((extremely detailed CG))))),((8k_wallpaper)), (1 girls:1.5),big top sleeves, floating,beautiful detailed eyes, overexposure,light shafts, soft focus, side blunt bangs, buttons, bare shoulders,(loli), character focus,wings,(((Transparent wings))),

[[((Wings made of golden lines,angel wing,gold halo around girl,many golden ribbon,Aureate headgear,gold magic circle in sky,ight, black sky):0.7):((galaxy background, snowflakes, night sky, black pupils, starts sky background, stars behind girl, view on sky,standing):0.8)],Elegant hair,Long hair,The flying golden lines,Messy golden lines,halo,hairs between eyes,Small breasts,ribbons, bowties,red eyes, golden pupil, white hair,flowing hair,disheveled hair,lowing long hair):(Delicate arms and hands):0.9]

隔离元素污染

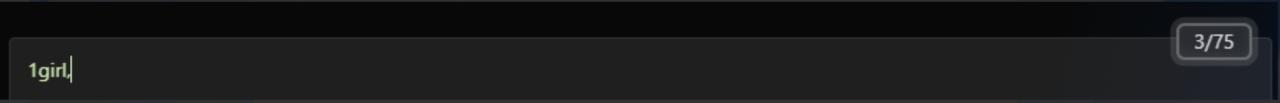

如果你在别人的提示词中看到了BREAK这个词,或者是看到了++++////\\这种毫无意义的符号,无需感到疑惑,这只是占位词。Stable Diffusion模型仅限在提示词中使用75个token,所以超过75个token的提示词就使用了clip拼接的方法,让我们能够正常使用。

BREAK这个词会直接占满当前剩下的token,后面的提示词将在第二段clip中处理。而早期++++////\\这些符号,大都是因为不知道BREAK这个词而添加上用于占token的。

输入BREAK之后你可以看到直接占满了剩下的token为什么要使用占位词/BREAK呢?

AI在生成图像的时候会将一些提示词的特征放到其他的物品上,例如我在提示词中写了white clothes和Flower background,那么很有可能在衣服上出现花的装饰。如果我们不想在衣服上出现花的装饰,那么比较简单的方法就是把这两个词放到两段clip中处理。

自然语言“咏唱法”

自然语言的效果实际上是SD模型原本的使用方法,但是由于novelai模型的训练方法和一部分LoRA模型训练的时候训练集的标注以tag为主,所以可能tag的表现更好一些。但既然是Stable diffusion模型,那么使用自然语言本身就没有什么问题,但是不一定真的效果就是更好的。例如下面提示词就混合了自然语言和tag,大家也可以自己尝试一下自然语言去写提示词。

flat design,

(official art:1.2)

(white background:1.2),

depth of field, double exposure,

(There is a big world tree with magic:1.2),

(She is inside the world tree:1.2),

1girl,solo,fullbody,

(She is a angel with beautiful detailed eyes with crystal textured hair with beautiful detailed face with (clothes)+(beautiful transparent wing)),

(She is a angel with red eyes with white hair with (clothes)+(light wings)),

(She is a girl with long flowing hair with the hair between the eyes),

(She with white dress with detached Sleeve with off_shoulder clothes),

(She with symmetrical wings with transparent wings with mechanical wings),

(She is a sitting girl with small breasts with (wariza:1.2)),

(She is far away form viewers and looking at viewers with (from side:0.5)),

(She is beside the floating cubes:1.4),

(super fucking cool golden light:1.2),

(white background:1.2),

irradiance particles, ray tracing,(The broken floor:1.3),

depth of field, tyndall effect, double exposure,

visual impact,((Ink mist,Coloured lead painting,[[Gouache painting]]):1.5)

(Glitch Art:1.414)请不要使用shit山负面

大量的负面提示词会对生成的图片产生灾难性的影响。新的tag串在编写的时候负面提示词是需要放到最后再添加的,因为无论如何负面提示词都会对画面产生一定的影响,并且很多影响是不可预见。这将会导致很多想要达到的效果无论如何也无法实现。实际上当年《元素法典》研究提示词的时候一般的操作是当生成图出现自己不想要的东西的时候再作为补充。

负面embedding也不是越多越好,负面embedding对构图会有影响,很多人以为越多越好从而叠一堆负面embedding,其实不用也一样能出好图。甚至好的手也不依赖负面embedding,有的时候手崩了即使用了负面embedding也不会很好的修复。

放这么多的负面embedding堆在一起,不但会严重影响提示词的准确性,还会严重影响生成图效果和模型,甚至于说能把大部分模型干成同一种风格。

前者未使用负面embedding,后者为使用负面embedding。可以明显的看到,使用embedding生成的图已经明显失去风格化5. 选择你的捍卫者“采样器”&调度器

采样器sampler就是去噪的方法,WebUI中内置了很多采样器,你也可以自己装载其中没有的其他采样器。包括一般使用的Euler A和UniPC,以及很多人都喜欢使用的DPM系列。

调度类型简单而言就是去噪速度。常见的调度类型有:Karras / Sgm_uniform / Exponential / ddim_uniform……,目前推荐使用 Exponential 方法,可以得到更好效果。

对于初学者来说,更推荐使用Euler A或者Unipc等生成图像较快的采样方法。

采样方法组成了图片生成的第一大要素,它决定同样的 prompt 下AI会选择以何种方式去噪点化以得到最终图片。同时,它还会决定运算速度。

采样方法组成了图片生成的第一大要素,它决定同样的 prompt 下 AI 会选择以何种方式去噪点化以得到最终图片。同时,它还会决定运算速度。

通常来讲, Euler A 是兼顾速度和质量的最优之选。而 DDIM 和 Euler 则在运气较好的情况下尤其以细腻的画风见长。 DPM系列 则是各有优劣,部分在低steps下有着极其良好的表现(DPM三兄弟在15~20步就差不多了)

当你审美疲劳时,也可以尝试更换方法也许可以带来新的风格。

6. 迭代步数(steps)

不同采样需要的采样steps不同。

例如Euler A/DPM A等都是非线性采样,结果并非随着采样步数的增加而增加质量。恰恰相反在大于一定采样步数只会质量会快速下降。对于此类采样器推荐的最大steps一般为50左右。(不绝对)

而Euler/DDIM等线性采样随着迭代步数的增加质量会增加。当然在早期“修手”的尝试中发现,这类采样器的steps数存在边际效应的问题,大于一定数值之后,增加steps带来的收益也不会很明显。

很多图直至steps500才会有明显的提升,而一般显卡拉500steps需要的耗时太长了,所以并不建议拉太高的steps。7. WebUI基本进阶用法

①渲染句式

在webui中,有几种非常好用的句式可以使用:

[A:B:X]代表执行A效果到X的进度(如0.4到40%的总步数),B从X的进度开始

[A:0.5]这样写的含义是从50%开始渲染A

[A::X]渲染到X的进度的时候停止A的渲染

[A|B]交替渲染A/B

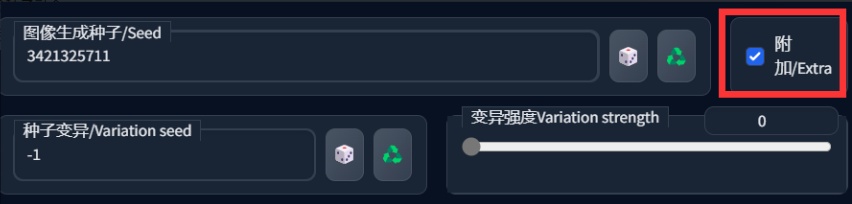

②种子变异

用于轻微调整生成图

大致的效果如图所示:随机差异种子可以选择其他种子,也可以随机抽取(-1),效果图是固定了差异种子

大致的效果如图所示:随机差异种子可以选择其他种子,也可以随机抽取(-1),效果图是固定了差异种子

好了,你已经学会基本用法了,尝试分析一下下面这串tag的分步吧

[[([(Delicate eyes,glowing eyes,red eyes, black pupil,(beautiful eyes:1.2),(serious),(gradient eyes)):[((messy_hair),(Long hair:1.2),(lightning),Lots of lightning,([white hair|Lavender hair]:1.3)):((Flowing hair:1.2),Long flowing hair,beautiful hair):0.6]:0.7],(Delicate face:1.2),(shoulder cutout),(Gorgeous clothes:1.3),(beautiful arms:1.2),(Characters stay away:1.4),(Small breasts:1.2),[[:((Scepter weapon,The thunder wand,Crystal texture of the hair):1.4):0.5]::0.9],[((lightning),many glowing ribbon,Shine tire,glowing magic circle in sky,(glowing halo around girl:1.3)):((exquisite Magic Circle:1.7),(Many purple flashes:1.4)):0.5],(Gorgeous accessories:1.2),(Gorgeous special effects:1.3),(highres:1.3),(magic:1.3),(glowing light:1.3),(exquisite magic array:1.2),(Strong vision),(Magic in hand:1.3),(starry sky:1.3),(huge Brilliant magic),(glowing light:1.2),(Dimensional space is broken),(lightning:1.3),god rays,night, black pupils,(clock method array:1.2),standing,Hair and lightning blend together,(Lightning ribbon:1.2)):(lightning:1.2):0.8]:(Delicate arms and hands):0.9]]8. 我的“法术”不听话了?

增加减少权重

有的时候,提示词会出现不听话/失效的现象。

当提示词失效的时候,不妨多增加权重,例如(1girl:1.2)/(1girl)

注意:这里的任何权重等的调整只能使用英文符号,使用全角/中文符号将不会起任何作用

一对小括号()意味着把括起来的 prompt 权重 * 1.1,中括号[]则是 / 1.1,大括号{}在 WEB-UI 中无调整权重作用,且会被作为 文本 而解析。

如果因为某些需求而要大量抬升权重,可以对 prompt 进行多次括号,比如((((prompt)))),这意味着将它的权重 * 1.1 四次,也就是 1.4641。但这个写法太吓人了,数括号也很浪费时间,所以应该直接为一个 prompt 赋予权重:

(prompt:权重乘数)

外层一定是小括号而非其它括号。比如 (red hair:1.5) 将直接给 red hair 赋予 1.5 权重,(red hair:0.8)将直接给red hair赋予 0.8权重,清晰简洁,便于自己回顾和他人理解,强烈推荐。

而除了整词权重之外,也可以进行部分权重,比如如下例子:

1 girl, white long (messy:1.2) hair, red eyes

将专门对 messy 部分赋予 * 1.2 权重,其它部分不受影响

高权重的元素会在画面中有着更大的占比或更强烈的存在感或更多的数量,是能可观地影响构图的原因之一。如果出现了(xxx:1.7)还无法正确的表达需要的效果时,那么大概率为模型无法识别这个提示词,或者模型本身的问题。

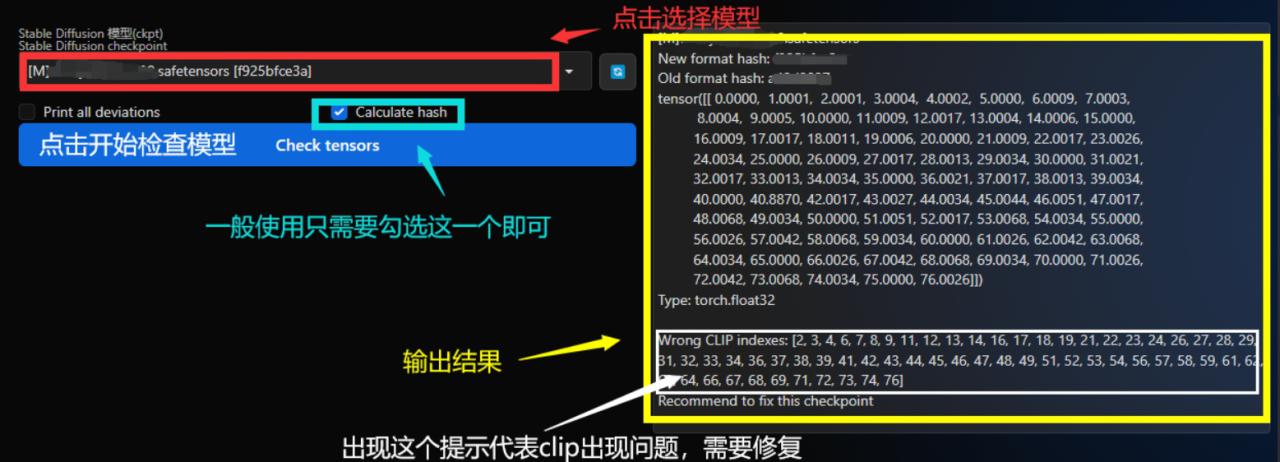

模型本身问题

例如模型的clip偏移:(这里要用到一个叫做CLIP tensors checker的插件)

clip偏移会影响模型对于对应位置的token语义的理解,有的时候就会造成你的提示词识别出现问题,详情可以查看早期 “微笑测试”实验 ,这里引用部分实验内容。

clip偏移会影响模型对于对应位置的token语义的理解,有的时候就会造成你的提示词识别出现问题,详情可以查看早期 “微笑测试”实验 ,这里引用部分实验内容。

后置链接:Stable Diffusion WebUI 从入门到卸载② | 吐司 tusi.cn

![图片[22]-Stable Diffusion WebUI 从入门到卸载①-AIGC-AI绘画部落](http://sdbbs.vvipblog.net/wp-content/uploads/2024/09/wxpay.png) 微信赞赏

微信赞赏![图片[23]-Stable Diffusion WebUI 从入门到卸载①-AIGC-AI绘画部落](http://sdbbs.vvipblog.net/wp-content/uploads/2024/09/zfbpay.png) 支付宝赞赏

支付宝赞赏

- 最新

- 最热

只看作者